El problema de las noticias falsas no es nuevo. Organizaciones señalan que el fenómeno, en ocasiones respaldado por gobiernos, se extiende años atrás. Pero, también es innegable que la democratización de herramientas habilitada por el Internet y la digitalización ha acelerado el proceso. Conforme la tecnología avanza, ya no son solo simples textos. Material complejo, como videos e imágenes, puede ser falsificado fácilmente gracias a la Inteligencia Artificial (IA), publicó Merca 2.0.

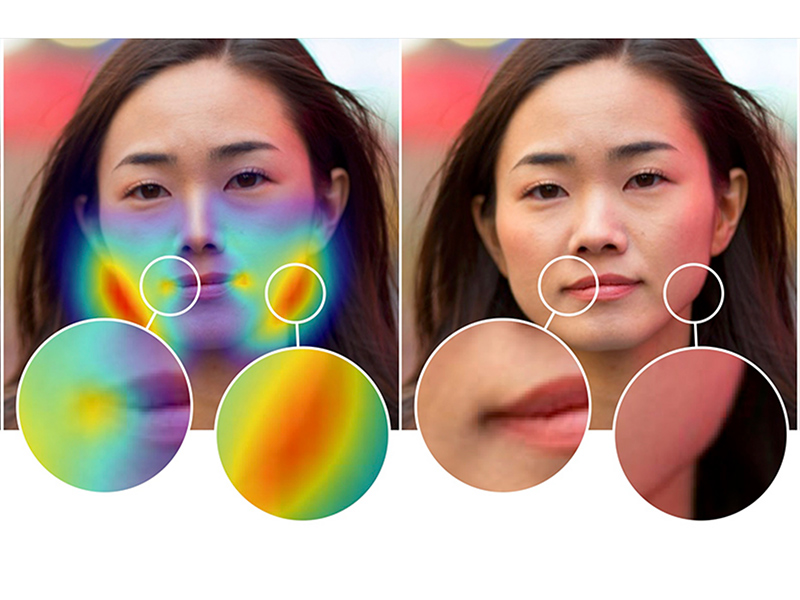

Algunas compañías tratan hacen su mejor esfuerzo para limitar la tendencia. Adobe anunció un nuevo proyecto de desarrollo, una investigación conjunta con la Universidad de California Berkley. Las dos organizaciones han creado una IA capaz de detectar imágenes y fotografías que hayan sido manipuladas por programas como Photoshop. El programa es capaz de detectar, con 99 por ciento de exactitud, modificaciones realizadas con la herramienta Liquify.

Liquify es comúnmente utilizada para hacer alteraciones menores a retratos, e incluso cambiar la expresión facial de las personas. Según Adobe, la herramienta de IA también es capaz de sugerir correcciones para revertir la imagen a su forma original. Pero esta capacidad todavía no está bien desarrollada. La marca reconoce tanto el valor creativo que representan sus productos como los problemas éticos que pueden causar en el tema de las fake news.

IA: el reto entre alteración y corrección

Varias compañías están retándose en el desarrollo de IA, tanto para la creación como la detección de contenido falso. Una unidad de investigación de Samsung presentó hace algunas semanas un programa capaz de “dar vida” a fotografías o retratos en pintura. Por su parte, Facebook trabaja ardua (y creativa)mente en sistemas capaces de monitorear el contenido tóxico en su plataforma. Incluso la industria del cine está haciendo uso de estos programas.

Pero la iniciativa de Adobe resalta un problema fundamental de la IA. La producción de contenidos falsos se ha refinado tanto, que incluso están teniendo repercusiones de seguridad nacional. Al mismo tiempo, es particularmente difícil desarrollar software capaz de detectar estas falsificaciones. Y es que muchos sistemas de este tipo entrenan autónomamente. Es decir, se enseñan a sí mismos a hacer la tarea que están tratando de realizar.

Para leer la nota completa, da clic aquí

Museo La Casa de Adobe, testigo del triunfo de la revolución

La construcción actual de La Casa de Adobe es una réplica de la vivienda que fue el punto estratégico donde Madero planeó la Toma de Juárez

Por Mauricio Rodríguez

Aprenden investigadores sobre cualidades bioclimáticas del adobe

Abordan en foro Ticrat importancia del patrimonio de la arquitectura de tierra

Por Redacción

Higuaín habría ocultado sobrepeso con Photoshop

El argentino subió una foto que parece alterada para retocar sus abdominales

Por Agencias

Las víctimas del Photoshop del 2016

Un montón de cosas realmente extrañas sucedieron en el 2016, pero no se puede negar que fue un gran año para las batallas de photoshop. Aquí una galería

Por Redacción